- Autor Lynn Donovan donovan@answers-technology.com.

- Public 2023-12-15 23:45.

- Última modificación 2025-01-22 17:22.

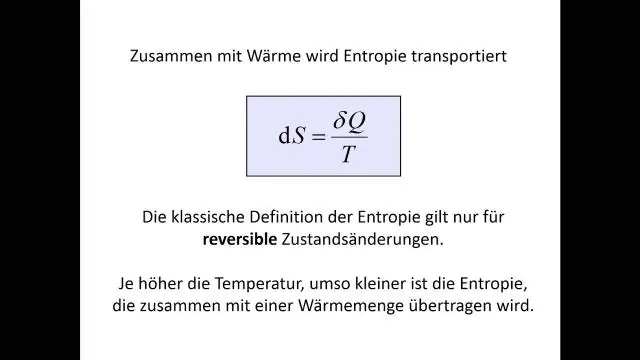

Ganancia de información = cuanto Entropía lo quitamos, entonces

Esto tiene sentido: mayor Ganancia de información = más Entropía eliminado, que es lo que queremos. En el caso perfecto, cada rama contendría solo un color después de la división, que sería cero entropía !

Además, ¿qué es la ganancia de información y la entropía en el árbol de decisiones?

Ganancia de información : Los ganancia de información se basa en la disminución de entropía después de que un conjunto de datos se divide en un atributo. Construyendo un árbol de decisión se trata de encontrar un atributo que devuelva el valor más alto ganancia de información (es decir, las ramas más homogéneas). Paso 1: Calcular entropía del objetivo.

De manera similar, ¿qué es la entropía en los datos? Información entropía es la tasa promedio a la que la información es producida por una fuente estocástica de datos . La medida de la información entropía asociado con cada posible datos valor es el logaritmo negativo de la función de masa de probabilidad para el valor: donde es la expectativa definida por la probabilidad.

En este sentido, ¿qué significa ganar información?

Ganancia de información calcula la reducción de entropía o sorpresa al transformar un conjunto de datos de alguna manera. Ganancia de información es la reducción de la entropía o la sorpresa al transformar un conjunto de datos y se utiliza a menudo en el entrenamiento de árboles de decisión.

¿Cuál es la definición de entropía en el árbol de decisión?

Definición : Entropía son las medidas de impureza, desorden o incertidumbre en un montón de ejemplos.

Recomendado:

¿Cuál es la definición de entropía en el árbol de decisión?

Entropía: un árbol de decisiones se construye de arriba hacia abajo a partir de un nodo raíz e implica dividir los datos en subconjuntos que contienen instancias con valores similares (homogéneos). El algoritmo ID3 utiliza la entropía para calcular la homogeneidad de una muestra

¿Qué es la tecnología de la información en el sistema de información gerencial?

El sistema de información de gestión (MIS) se refiere a una gran infraestructura utilizada por una empresa o corporación, mientras que la tecnología de la información (TI) es un componente de esa infraestructura que se utiliza para recopilar y transmitir datos. La tecnología de la información apoya y facilita el empleo de ese sistema

¿Qué tipo de disco óptico contiene más información que un CD o un DVD?

Blu-ray es un formato de disco óptico como CD y DVD. Fue desarrollado para grabar y reproducir videos de alta definición (HD) y para almacenar grandes cantidades de datos. Mientras que un CD puede contener 700 MB de datos y un DVD básico puede contener 4,7 GB de datos, un solo disco Blu-ray puede contener hasta 25 GB de datos

¿Qué es la ganancia en un amplificador?

En electrónica, la ganancia es una medida de la capacidad de un circuito de dos puertos (a menudo un amplificador) para aumentar la potencia o amplitud de una señal desde la entrada al puerto de salida agregando energía convertida de alguna fuente de alimentación a la señal. A menudo se expresa utilizando las unidades de decibelios logarítmicos (dB) ('dBgain')

¿Qué es la entropía en la minería de texto?

La entropía se define como: La entropía es la suma de la probabilidad de cada etiqueta multiplicada por la probabilidad logarítmica de esa misma etiqueta. ¿Cómo puedo aplicar la entropía y la entropía máxima en términos de minería de texto?