- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Última modificación 2025-01-22 17:22.

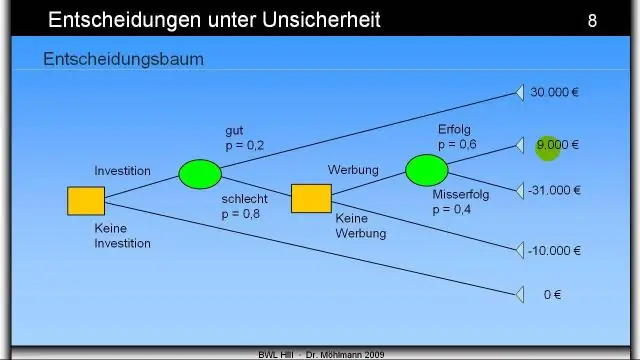

Entropía : A árbol de decisión se construye de arriba hacia abajo desde un nodo raíz e implica dividir los datos en subconjuntos que contienen instancias con valores similares (homogéneos). Usos del algoritmo ID3 entropía para calcular la homogeneidad de una muestra.

La gente también pregunta, ¿cuál es la definición de entropía en el aprendizaje automático?

Entropía , en lo que se refiere a aprendizaje automático , es una medida de la aleatoriedad de la información que se procesa. Cuanto mayor sea el entropía , más difícil es sacar conclusiones de esa información. Lanzar una moneda al aire es un ejemplo de una acción que proporciona información aleatoria. Esta es la esencia de entropía.

Además de lo anterior, ¿qué es la ganancia de información y la entropía en el árbol de decisiones? los ganancia de información se basa en la disminución de entropía después de que un conjunto de datos se divide en un atributo. Construyendo un árbol de decisión se trata de encontrar un atributo que devuelva el valor más alto ganancia de información (es decir, las ramas más homogéneas). El resultado es el Ganancia de información , o disminuir en entropía.

También sepa, ¿cuál es el valor mínimo de entropía en un árbol de decisión?

Entropía es más bajo en los extremos, cuando la burbuja no contiene instancias positivas o solo instancias positivas. Es decir, cuando la burbuja es pura el desorden es 0. Entropía es más alto en el medio cuando la burbuja se divide uniformemente entre instancias positivas y negativas.

¿Qué es la entropía en el bosque aleatorio?

¿Qué es la entropía? y por qué la información ganada es importante Decisión ¿Árboles? Nasir Islam Sujan. 29 de junio de 2018 · Lectura de 5 min. Según Wikipedia, Entropía se refiere al desorden o la incertidumbre. Definición: Entropía son las medidas de impureza, desorden o incertidumbre en un montón de ejemplos.

Recomendado:

¿Cuál es la mejor definición de modelo de seguridad?

Un modelo de seguridad es una evaluación técnica de cada parte de un sistema informático para evaluar su concordancia con los estándares de seguridad. D. Un modelo de seguridad es el proceso de aceptación formal de una configuración certificada

¿Cuál es la mejor explicación de las variables de decisión?

Una variable de decisión es una cantidad que controla el tomador de decisiones. Por ejemplo, en un modelo de optimización para la programación del trabajo de parto, la cantidad de enfermeras a emplear durante el turno de la mañana en una sala de emergencias puede ser una variable de decisión. OptQuest Engine manipula las variables de decisión en busca de sus valores óptimos

¿Cuál es la profundidad de un árbol de decisiones?

La profundidad de un árbol de decisión es la longitud del camino más largo desde una raíz hasta una hoja. El tamaño de un árbol de decisión es el número de nodos del árbol. Tenga en cuenta que si cada nodo del árbol de decisión toma una decisión binaria, el tamaño puede ser tan grande como 2d + 1 − 1, donde d es la profundidad

¿Cuál es la estrategia del árbol de prisioneros de guerra?

Una estrategia validada por investigación, POW es un dispositivo mnemónico diseñado para ayudar a los estudiantes a estructurar cualquier tipo de escritura. TREE también es un dispositivo mnemónico que los estudiantes pueden usar para organizar sus ideas. Organizar y generar notas e ideas para cada parte del ÁRBOL

¿Es el árbol de decisión una regresión?

Árbol de decisión: regresión. El árbol de decisiones crea modelos de regresión o clasificación en forma de estructura de árbol. El nodo de decisión más alto en un árbol que corresponde al mejor predictor llamado nodo raíz. Los árboles de decisión pueden manejar datos categóricos y numéricos