Tabla de contenido:

- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Última modificación 2025-01-22 17:22.

Para habilitar el servidor de historial de Spark:

- Cree un directorio para los registros de eventos en el sistema de archivos DSEFS: dse hadoop fs -mkdir / spark $ dse hadoop fs -mkdir / spark / events.

- Cuando el registro de eventos está habilitado, el comportamiento predeterminado es que se guarden todos los registros, lo que hace que el almacenamiento aumente con el tiempo.

Además de esto, ¿cómo configuro un servidor Spark History?

Para habilitar el servidor de historial de Spark:

- Cree un directorio para los registros de eventos en el sistema de archivos DSEFS: dse hadoop fs -mkdir / spark $ dse hadoop fs -mkdir / spark / events.

- Cuando el registro de eventos está habilitado, el comportamiento predeterminado es que se guarden todos los registros, lo que hace que el almacenamiento aumente con el tiempo.

Del mismo modo, ¿cómo encuentro la URL de mi servidor Spark History? Por ejemplo, para el servidor de historia , normalmente serían accesibles en https:// < servidor - url >: 18080 / api / v1, y para una aplicación en ejecución, en https:// localhost: 4040 / api / v1. En la API, se hace referencia a una aplicación por su ID de aplicación, [app-id].

Del mismo modo, ¿qué es el servidor Spark History?

los El servidor de historial de Spark es una herramienta de seguimiento que muestra información sobre las Chispa - chispear aplicaciones. Esta informacion es extraído de los datos que las aplicaciones escriben de forma predeterminada en un directorio en el sistema de archivos distribuido de Hadoop (HDFS).

¿Qué es Sparkui?

La interfaz de usuario web de Spark le permite ver una lista de las etapas y tareas del programador, información ambiental, información sobre los ejecutores en ejecución y más. Vea esta demostración de 30 minutos para conocer: Componentes y ciclo de vida de un programa Spark. Cómo se ejecuta su aplicación Spark en un clúster de Hadoop.

Recomendado:

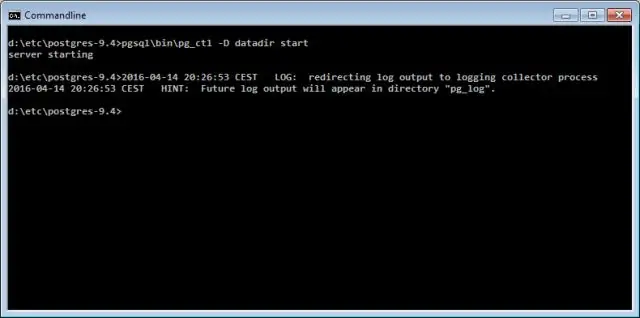

¿Cómo inicio el servidor GlassFish desde el símbolo del sistema?

Para iniciar el servidor GlassFish mediante la línea de comandos El número de puerto del servidor GlassFish: el valor predeterminado es 8080. El número de puerto del servidor de administración: el valor predeterminado es 4848. Un nombre de usuario y contraseña de administración: el nombre de usuario predeterminado es admin y, por defecto, ninguna contraseña es requerido

¿Cómo inicio un servidor bitbucket?

Para iniciar Bitbucket Data Center (no inicia la instancia de Elasticsearch incluida en Bitbucket) Cambie a su Ejecutar este comando: start-bitbucket.sh --no-search

No se pudo conectar el servidor. Es posible que no se esté ejecutando. ¿No se puede conectar al servidor MySQL en 127.0 0.1 10061?

Si el servidor MySQL se ejecuta en Windows, puede conectarse mediante TCP / IP. También debe verificar que el puerto TCP / IP que está utilizando no haya sido bloqueado por un firewall o un servicio de bloqueo de puertos. El error (2003) No se puede conectar al servidor MySQL en 'servidor' (10061) indica que la conexión de red ha sido rechazada

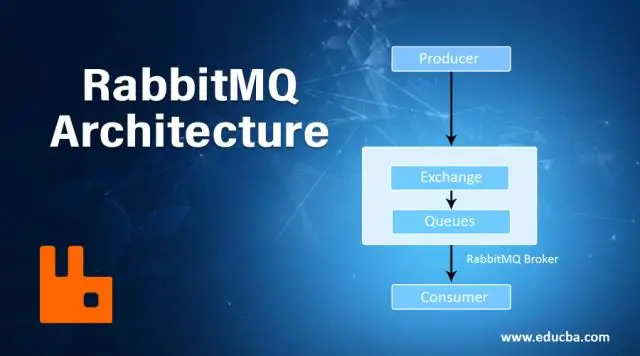

¿Cómo inicio el servidor RabbitMQ?

En el menú Inicio de Windows, seleccione Todos los programas> Servidor RabbitMQ> Iniciar servicio para iniciar el servidor RabbitMQ. El servicio se ejecuta en el contexto de seguridad de la cuenta del sistema sin necesidad de que el usuario inicie sesión en una consola. Utilice el mismo proceso para detener, reinstalar y eliminar el servicio

¿Cuál es el protocolo de servidor a servidor?

IMAP (Protocolo de acceso a mensajes de Internet): es un protocolo estándar para acceder al correo electrónico desde su servidor local. IMAP es un protocolo cliente / servidor en el que su servidor de Internet recibe y guarda el correo electrónico. Como esto requiere solo una pequeña transferencia de datos, esto funciona bien incluso con una conexión lenta como un módem