Tabla de contenido:

- Autor Lynn Donovan [email protected].

- Public 2024-01-18 08:23.

- Última modificación 2025-01-22 17:22.

Los principales parámetros de configuración que los usuarios deben especificar en el marco "MapReduce" son:

- Trabajos ubicaciones de entrada en el sistema de archivos distribuido.

- Trabajos ubicación de salida en el sistema de archivos distribuido.

- Formato de entrada de datos.

- Formato de salida de datos.

- Clase que contiene la función de mapa.

- Clase que contiene la función de reducción.

Aquí, ¿cuáles son los principales parámetros de configuración en un programa MapReduce?

Los principales parámetros de configuración en el marco "MapReduce" son:

- Ingrese la ubicación de los trabajos en el sistema de archivos distribuido.

- Ubicación de salida de trabajos en el sistema de archivos distribuido.

- El formato de entrada de datos.

- El formato de salida de los datos.

- La clase que contiene la función de mapa.

- La clase que contiene la función de reducción.

También se puede preguntar, ¿cuáles son los parámetros de los mapeadores y reductores? Los cuatro parámetros para los mapeadores son:

- LongWritable (entrada)

- entrada de texto)

- texto (salida intermedia)

- IntWritable (salida intermedia)

También la pregunta es, ¿cuáles son los componentes principales del trabajo MapReduce?

- Clase de controlador principal que proporciona parámetros de configuración del trabajo.

- Clase de asignador que debe extender org. apache. hadoop. Mapa reducido. Mapper y proporciona implementación para el método map ().

- Clase reductora que debería extender org. apache. hadoop. Mapa reducido. Clase reductora.

¿Qué es el particionador y cómo ayuda en el proceso de trabajo de MapReduce?

Particionador en Trabajo MapReduce La ejecución controla la partición de las claves de las salidas de mapas intermedias. Con el ayuda de la función hash, la clave (o un subconjunto de la clave) deriva el dividir . Los registros que tienen el mismo valor de clave entran en el mismo dividir (dentro de cada mapeador).

Recomendado:

¿Cuál es la diferencia entre ejecutar la configuración y la configuración de inicio?

Una configuración en ejecución reside en la RAM del dispositivo, por lo que si un dispositivo pierde energía, se perderán todos los comandos configurados. Una configuración de inicio se almacena en la memoria no volátil de un dispositivo, lo que significa que todos los cambios de configuración se guardan incluso si el dispositivo pierde energía

¿Cuáles son los 4 criterios principales que se deben utilizar al evaluar los recursos?

Los criterios de evaluación comunes incluyen: propósito y público objetivo, autoridad y credibilidad, precisión y confiabilidad, actualidad y oportunidad, y objetividad o sesgo. Cada uno de estos criterios se explicará con más detalle a continuación

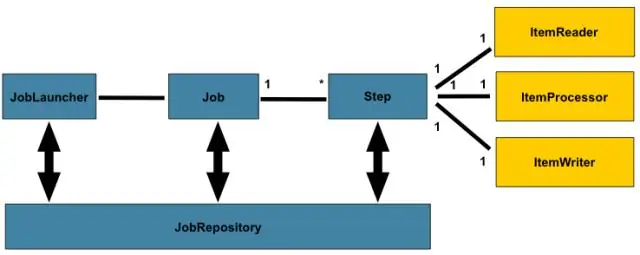

¿Qué son los parámetros de trabajo en Spring Batch?

JobParameters es un conjunto de parámetros que se utilizan para iniciar un trabajo por lotes. Los parámetros de trabajo se pueden utilizar para identificación o incluso como datos de referencia durante la ejecución del trabajo. Tienen nombres reservados, por lo que para acceder a ellos podemos usar Spring Expression Language

¿Cuáles son los componentes principales de la gestión de archivos? Marque todos los que correspondan

Los componentes principales de la gestión de archivos son el almacenamiento de datos, los metadatos de los archivos y el sistema de archivos. ¿Cuáles son los componentes principales de la gestión de archivos? Marque todo lo que corresponda. Puede tener muchos procesos en ejecución para un programa

¿Cuáles de los siguientes son los tres tipos principales de sistemas de gestión del conocimiento?

Hay tres tipos principales de sistemas de gestión del conocimiento: sistemas de gestión del conocimiento en toda la empresa, sistemas de trabajo del conocimiento y técnicas inteligentes