- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Última modificación 2025-01-22 17:22.

Ingestión de datos es el proceso de obtención e importación datos para uso inmediato o almacenamiento en una base de datos. Ingerir algo es "tomar algo o absorber algo". Datos se puede transmitir en tiempo real o ingerido en lotes.

También sepa, ¿qué es la canalización de ingestión de datos?

Canalización de ingestión de datos . A canalización de ingestión de datos se mueve en streaming datos y por lotes datos de bases de datos preexistentes y datos almacenes a un datos lago. Para una basada en HDFS datos lago, herramientas como Kafka, Hive o Spark se utilizan para ingesta de datos . Kafka es un popular ingesta de datos herramienta que admite transmisión datos.

Además, ¿cómo ingiere Hadoop los datos? Hadoop utiliza un sistema de archivos distribuido que está optimizado para leer y escribir archivos grandes. Al escribir a HDFS , datos se "cortan" y se replican en los servidores en un Hadoop grupo. El proceso de segmentación crea muchas subunidades pequeñas (bloques) del archivo más grande y las escribe de forma transparente en los nodos del clúster.

En segundo lugar, ¿qué son las herramientas de ingestión de datos?

Herramientas de ingestión de datos proporcionar un marco que permita a las empresas recopilar, importar, cargar, transferir, integrar y procesar datos de una amplia gama de datos fuentes. Facilitan la datos proceso de extracción apoyando varios datos protocolos de transporte.

¿Cuál es su comprensión de la integración y la ingestión de datos?

Ingestión de datos es los proceso de ingiriendo datos de un sistema a otro. Integración de datos permite diferentes datos tipos (como datos conjuntos, documentos y tablas) para ser fusionados y utilizados por aplicaciones para procesos personales o comerciales.

Recomendado:

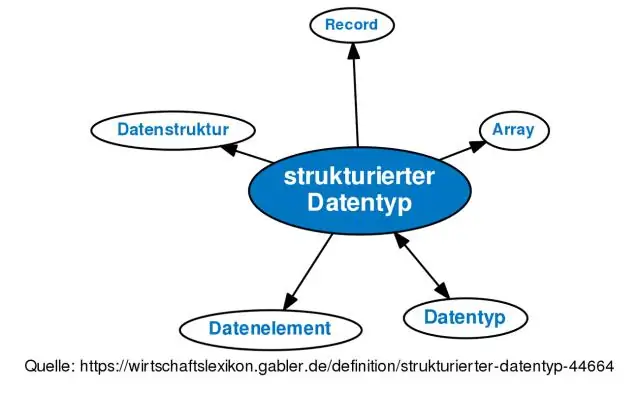

¿Qué es el tipo de datos y la estructura de los datos?

Una estructura de datos es una forma de describir una cierta forma de organizar partes de datos para que las operaciones y los logritmos se puedan aplicar más fácilmente. Un tipo de datos describeespecies de datos que comparten una propiedad común. Por ejemplo, un tipo de datos entero describe cada entero que la computadora puede manejar

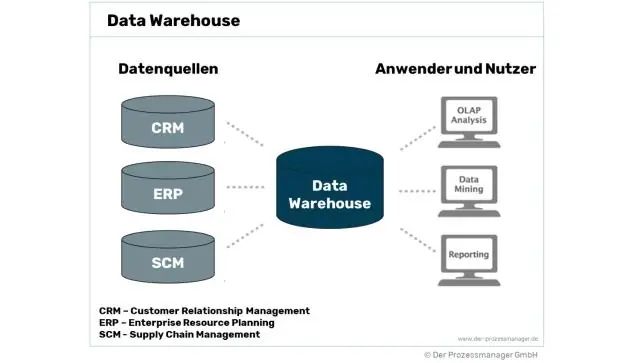

¿Qué son los datos transitorios en el almacén de datos?

Los datos transitorios son datos que se crean dentro de una sesión de la aplicación, que no se guardan en la base de datos después de que se termina la aplicación

¿Por qué una base de datos plana es menos eficaz que una base de datos relacional?

Una sola tabla de archivo plano es útil para registrar una cantidad limitada de datos. Pero una base de datos de archivo plano grande puede ser ineficaz, ya que ocupa más espacio y memoria que una base de datos relacional. También requiere que se agreguen nuevos datos cada vez que ingresa un nuevo registro, mientras que una base de datos relacional no lo hace

¿Qué es la minería de datos y qué no es la minería de datos?

La minería de datos se realiza sin ninguna hipótesis preconcebida, por lo que la información que proviene de los datos no es para responder preguntas específicas de la organización. No minería de datos: el objetivo de la minería de datos es la extracción de patrones y conocimiento de grandes cantidades de datos, no la extracción (minería) de datos en sí

¿Por qué el almacenamiento de datos orientado a columnas hace que el acceso a los datos en los discos sea más rápido que el almacenamiento de datos orientado a filas?

Las bases de datos orientadas a columnas (también conocidas como bases de datos en columnas) son más adecuadas para cargas de trabajo analíticas porque el formato de datos (formato de columna) se presta a un procesamiento de consultas más rápido: escaneos, agregación, etc. columnas) contiguas