Tabla de contenido:

- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Última modificación 2025-01-22 17:22.

Para activar TensorFlow, abra una instancia de Amazon Elastic Compute Cloud (Amazon EC2) de DLAMI con Conda

- Para TensorFlow y Keras 2 en Python 3 con CUDA 9.0 y MKL-DNN, ejecute este comando: $ source active tensorflow_p36.

- Para TensorFlow y Keras 2 en Python 2 con CUDA 9.0 y MKL-DNN, ejecute este comando:

En consecuencia, ¿TensorFlow se ejecuta en AWS?

TensorFlow ™ permite a los desarrolladores comenzar rápida y fácilmente con el aprendizaje profundo en la nube. usted pueden empezar AWS con una gestión totalmente TensorFlow experiencia con Amazonas SageMaker, una plataforma para crear, entrenar e implementar modelos de aprendizaje automático a escala.

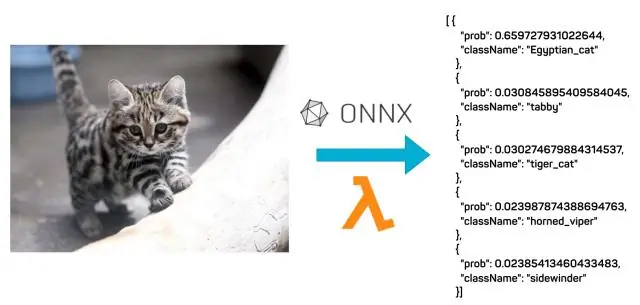

También sepa, ¿qué es AWS TensorFlow? Categoría: Tensorflow sobre AWS TensorFlow es una biblioteca de aprendizaje automático (ML) de código abierto ampliamente utilizada para desarrollar redes neuronales profundas (DNN) de gran peso que requieren entrenamiento distribuido utilizando múltiples GPU en múltiples hosts.

También la pregunta es, ¿cómo ejecuto el aprendizaje automático de AWS?

Introducción al aprendizaje profundo mediante la AMI de aprendizaje profundo de AWS

- Paso 1: Abra la Consola EC2.

- Paso 1b: elija el botón Iniciar instancia.

- Paso 2a: seleccione la AMI de aprendizaje profundo de AWS.

- Paso 2b: en la página de detalles, elija Continuar.

- Paso 3a: seleccione un tipo de instancia.

- Paso 3b: Inicie su instancia.

- Paso 4: cree un nuevo archivo de clave privada.

- Paso 5: haga clic en Ver instancia para ver el estado de su instancia.

¿Cómo sirve un modelo de TensorFlow?

- Crea tu modelo. Importe el conjunto de datos Fashion MNIST. Entrena y evalúa tu modelo.

- Guarde su modelo.

- Examine su modelo guardado.

- Sirva su modelo con TensorFlow Serving. Agregue el URI de distribución de TensorFlow Serving como fuente del paquete: Instale TensorFlow Serving.

- Realiza una solicitud a tu modelo en TensorFlow Serving. Realice solicitudes de REST.

Recomendado:

¿Cómo ejecuto casos de prueba de JUnit en Eclipse?

La forma más sencilla de ejecutar un solo método de prueba JUnit es ejecutarlo desde el editor de clases del caso de prueba: coloque el cursor en el nombre del método dentro de la clase de prueba. Presione Alt + Shift + X, T para ejecutar la prueba (o haga clic con el botón derecho, Ejecutar como> Prueba JUnit). Si desea volver a ejecutar el mismo método de prueba, simplemente presione Ctrl + F11

¿Cómo ejecuto la aplicación AVD?

Ejecutar en un emulador En Android Studio, cree un dispositivo virtual de Android (AVD) que el emulador pueda usar para instalar y ejecutar su aplicación. En la barra de herramientas, seleccione su aplicación en el menú desplegable de configuraciones de ejecución / depuración. En el menú desplegable del dispositivo de destino, seleccione el AVD en el que desea ejecutar su aplicación. Haga clic en Ejecutar

¿Cómo ejecuto un programa Clojure?

Construyendo y ejecutando un programa Clojure manualmente: Cargue el archivo Clojure repl. Cargue su código Clojure (asegúrese de que incluya: gen-class) Compile su código Clojure. Por defecto, el código se coloca en el directorio de clases. Ejecute su código, asegurándose de que la ruta de clases incluya el directorio de clases y clojure. frasco

¿Cómo ejecuto un programa Java después de la instalación?

Cómo ejecutar un programa java Abra una ventana del símbolo del sistema y vaya al directorio donde guardó el programa java (MyFirstJavaProgram. Java). Escriba 'javac MyFirstJavaProgram. java 'y presione enter para compilar su código. Ahora, escriba 'java MyFirstJavaProgram' para ejecutar su programa. Podrás ver el resultado impreso en la ventana

¿Cómo ejecuto un contenedor de Docker en AWS?

Implemente contenedores de Docker Paso 1: configure su primera ejecución con Amazon ECS. Paso 2: cree una definición de tarea. Paso 3: configura tu servicio. Paso 4: configura tu clúster. Paso 5: Inicie y vea sus recursos. Paso 6: Abra la aplicación de muestra. Paso 7: Elimina tus recursos