- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Última modificación 2025-01-22 17:22.

Tiempo Chispa - chispear soporta la carga archivos desde el local sistema de archivos, requiere que el archivos están disponibles en la misma ruta en todos los nodos de su clúster. Algunos sistemas de archivos de red, como NFS, AFS y la capa NFS de MapR, están expuestos al usuario como un sistema de archivos normal.

Posteriormente, también se puede preguntar, ¿cómo ejecuto Spark en modo local?

En modo local , Chispa - chispear trabajos correr en una sola máquina, y se ejecutan en paralelo utilizando subprocesos múltiples: esto restringe el paralelismo a (como máximo) la cantidad de núcleos en su máquina. Para correr trabajos en modo local , primero debe reservar una máquina a través de SLURM en modo interactivo modo e inicie sesión en él.

Además de arriba, ¿qué es SC textFile? Archivo de texto es un método de una org. apache. SparkContext clase que lee un Archivo de texto desde HDFS, un sistema de archivos local (disponible en todos los nodos) o cualquier URI del sistema de archivos compatible con Hadoop, y devuélvalo como un RDD de cadenas.

En este sentido, ¿qué es un archivo Spark?

los Archivo Spark es un documento donde guardas toda tu bondad creativa. Fue definido por el autor Stephen Johnson. Entonces, en lugar de rascar notas en un Post-it® en medio de la noche o dedicar diferentes diarios a las ideas, pones todos tus conceptos en uno. expediente.

¿Qué es la chispa de recolección paralelizada?

Describimos las operaciones en conjuntos de datos distribuidos más adelante. Colecciones paralelas se crean llamando a JavaSparkContext paralelizar método en un existente Colección en su programa de controlador. Los elementos del colección se copian para formar un conjunto de datos distribuido que se puede operar en paralelo.

Recomendado:

¿Puede Python leer archivos ZIP?

Para trabajar en archivos zip usando Python, usaremos un módulo de Python incorporado llamado zipfile. print ('¡Listo!' ZipFile es una clase de módulo zipfile para leer y escribir archivos zip. Aquí solo importamos la clase ZipFile del módulo zipfile

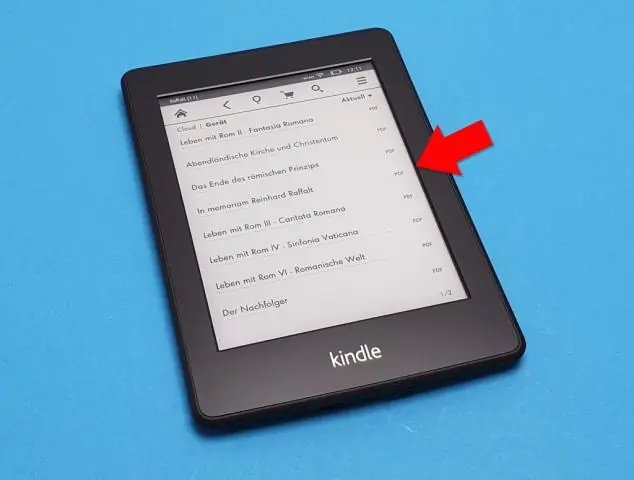

¿Puede finale leer archivos PDF?

Consejo profesional: también puede abrir el archivo en Final seleccionando el archivo en su buscador y haciendo clic derecho. Luego seleccione "Abrir con …" y elija Finale en la barra de programa. ¡Felicidades! Importó con éxito un archivo PDF a Finale usando ScanScore

¿Nook puede leer archivos PDF?

Los documentos que puede agregar a Nook incluyen archivos PDF, que pueden ser libros u otros documentos más breves. Los archivos PDF en el Nook se pueden leer como cualquier otro libro comprado, y puedes sincronizar el dispositivo, copiando los documentos de tu computadora al Nook. Haz doble clic en la carpeta "Libros" o "Documentos" en la unidad de disco de tu Nook

¿Puede Windows 10 leer archivos sin formato?

Windows 10 no se envía con soporte nativo para la vista previa de archivos de imagen sin procesar, lo que significa que los usuarios no pueden ver miniaturas o metadatos en la aplicación Fotos o el Explorador de archivos de Windows. Sin embargo, Microsoft tiene una solución para los fotógrafos que necesitan esta capacidad, y se llama Extensión de imagen sin procesar

¿Puede Python leer archivos .MAT?

A partir de la versión 7.3 de Matlab, los archivos mat se guardan realmente usando el formato HDF5 de forma predeterminada (excepto si usa el indicador -vX en el momento de guardar, consulte en Matlab). Estos archivos se pueden leer en Python usando, por ejemplo, el paquete PyTables o h5py