- Autor Lynn Donovan [email protected].

- Public 2023-12-15 23:45.

- Última modificación 2025-06-01 05:07.

Conjuntos de datos distribuidos resistentes ( RDD ) es una estructura de datos fundamental de Spark. Es una colección distribuida inmutable de objetos. RDD puede contener cualquier tipo de Python, Java o Scala objetos, incluidas las clases definidas por el usuario. Formalmente, un RDD es una colección de registros particionada de solo lectura.

También la pregunta es, ¿cuál es la diferencia entre RDD y DataFrame?

RDD - RDD es una colección distribuida de elementos de datos repartidos en muchas máquinas en el grupo. RDD son un conjunto de objetos Java o Scala que representan datos. Marco de datos - A Marco de datos es una colección distribuida de datos organizados en columnas con nombre. Es conceptualmente igual a una mesa. en un base de datos relacional.

Además, ¿cómo se distribuye RDD? Elástico Repartido Conjuntos de datos ( RDD ) Son un repartido colección de objetos, que se almacenan en memoria o en discos de diferentes máquinas de un clúster. Un solo RDD se puede dividir en varias particiones lógicas para que estas particiones se puedan almacenar y procesar en diferentes máquinas de un clúster.

¿Cómo funciona Spark RDD?

RDD en Chispa - chispear tener una colección de registros que contengan particiones. RDD en Chispa - chispear se dividen en pequeños fragmentos lógicos de datos, conocidos como particiones, cuando se ejecuta una acción, se inicia una tarea por partición. Particiones en RDD son las unidades básicas del paralelismo.

¿Cuál es RDD o DataFrame más rápido?

RDD - Mientras realiza operaciones simples de agrupación y agregación RDD La API es más lenta. Marco de datos - Al realizar análisis exploratorios, crear estadísticas agregadas sobre datos, marcos de datos están más rápido . RDD - Cuando desee acciones y transformaciones de bajo nivel, utilizamos RDD . Además, cuando necesitamos abstracciones de alto nivel, usamos RDD.

Recomendado:

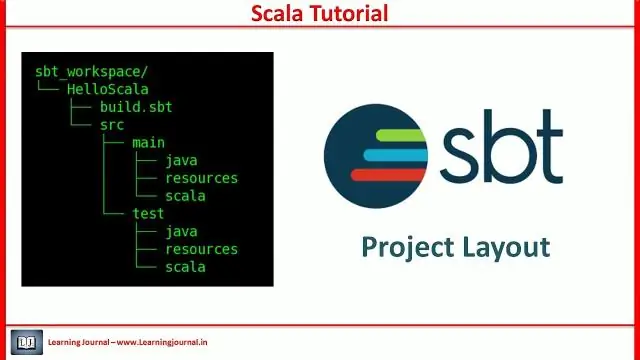

¿Qué es el proyecto SBT en Scala?

Sbt es una herramienta de compilación de código abierto para proyectos Scala y Java, similar a Maven y Ant de Java. Sus principales características son: Soporte nativo para compilar código Scala e integrarse con muchos marcos de prueba Scala. Compilación, prueba e implementación continuas

¿Qué son los actores en Scala?

La construcción de concurrencia principal de Scala son los actores. Los actores son básicamente procesos concurrentes que se comunican mediante el intercambio de mensajes. Los actores también pueden verse como una forma de objetos activos donde invocar un método corresponde a enviar un mensaje

¿Qué es DataFrame en Spark Scala?

Un Spark DataFrame es una colección distribuida de datos organizados en columnas con nombre que proporciona operaciones para filtrar, agrupar o calcular agregados, y se puede usar con Spark SQL. Los DataFrames se pueden construir a partir de archivos de datos estructurados, RDD existentes, tablas en Hive o bases de datos externas

¿Qué es la anulación en Scala?

Anulación del método Scala. Cuando una subclase tiene el mismo método de nombre que el definido en la clase principal, se conoce como anulación de método. Cuando la subclase desea proporcionar una implementación específica para el método definido en la clase principal, anula el método de la clase principal

¿Qué es la clase implícita en Scala?

Scala 2.10 introdujo una nueva característica llamada clases implícitas. Una clase implícita es una clase marcada con la palabra clave implícita. Esta palabra clave hace que el constructor principal de la clase esté disponible para conversiones implícitas cuando la clase está dentro del alcance. Se propusieron clases implícitas en SIP-13